最近,自动化所类脑智能研究中心曾毅研究员团队在一项研究中总结归纳了七条受脑启发的学习准则,并成功应用于脉冲神经网络学习。通过组合不同的受脑启发的规则,实验研究验证了:随着越来越多的、经过仔细选择的、受脑启发的规则的引入,深层脉冲神经网络能够得到越来越好的分类性能。

虽然相比传统的人工神经元而言,脉冲神经元已具备更扎实的生物真实性,然而传统的脉冲神经网络模型仅仅抓住了脑信息处理过程中初步的局部学习训练法则。由于生物脑在学习过程中协同了若干个法则,因此我们不能奢望仅仅采用较少的法则设计的类脑脉冲神经网络模型就能够达到甚至超越生物脑的各种学习能力。

研究团队提出的7条学习准则都来源于对生物脑的实验研究,并各自从不同的侧面反映了生物网络的学习特性,如神经元的动态分配、突触的自适应生长和消亡机制、不同的突触可塑性学习机制(如不同类型的时序依赖突触可塑性)、网络背景噪声对学习的调控机制、兴奋性和抑制性神经元的比例对学习的调节机制等。

在这些学习准则中,神经元的动态分配、突触的生成与消亡、可塑性模型等被认为是脑神经网络处理信息的重要特性。研究团队将上述受脑启发的规则引入脉冲神经网络模型,希望提升传统脉冲神经网络的效率。

据论文作者之一张铁林博士介绍,该研究提出的脉冲神经网络模型主要包含三部分:脉冲生成层、隐层、输出层。在脉冲生成层中,静态图像输入被转化为脉冲序列。在隐层中,神经元的动态分配(R1, R2)、突触的生长消亡 (R3, R4)、不同类型的背景噪声(R5)、不同类型的脉冲时序依赖可塑性模型 (R6)、兴奋和抑制性神经元(R7)被作为类脑的重要机制引入。在输出层,兴奋性神经元负责进行分类,抑制性神经元实现赢者通吃的机制(WTA)。实验验证方面,研究采用了手写数字数据集MNIST。

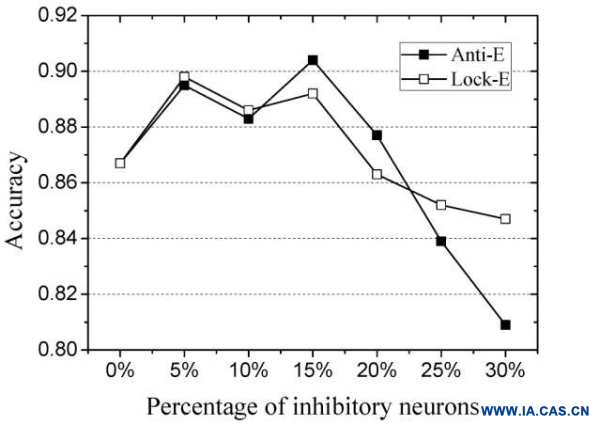

实验表明,当引入精心选择的类脑机制后,模型的正确率会逐步提升。

图1. 通过不断引入不同的类脑机制提升脉冲神经网络的正确率

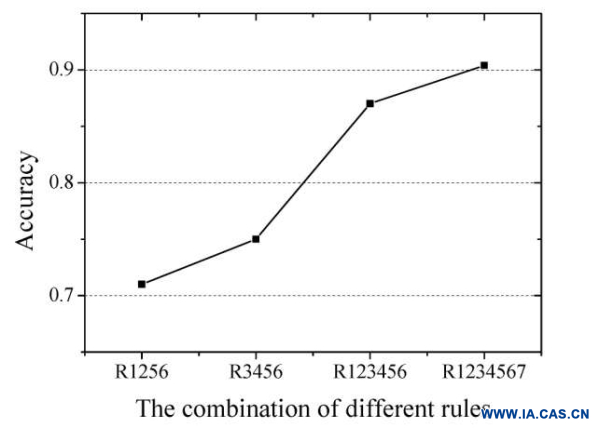

图2. 两种抑制性神经元及其比例对模式识别类任务正确率的影响

访谈过程中,曾毅研究员表示,模型性能的最优化并不是本研究追求的最终目标。团队提出的模型特点在于计算机制上相比传统神经网络模型更具生物可解释性,在这种情况下,通过计算建模理解脑信息处理机制与过程的意义,以及由此带来的启发,要远大于对性能的追求。

据曾毅研究员介绍,本项研究工作的主要结论是:每一项引入的机制对于脉冲神经网络处理模式识别类问题都有自己独特的贡献,并且相互不可替代 (如图1所示)。此外,在MNIST数据集上取得最好模式识别效率的兴奋性和抑制性神经元比例为15%抑制性神经元,85%兴奋性神经元(如图2所示),这与生物脑皮层感知区域的兴奋性与抑制性神经元比例十分接近,从计算的视角初步佐证了脑神经系统在向解决认知任务优化的方向进化。