自计算机产生以来,让计算机以更高效便捷的自然对话方式,来协助人类完成任务一直是人类的梦想。在语音识别、语言理解、对话管理、语言生成、语音合成等技术充分发展的基础上,多模态自然人机对话成为人机协同完成任务的一种重要形式。现在,人机对话系统已经由早期的电话语音订票、面向问答的语音搜索为主,发展到现在的语音对话为主的人机协同阅读和人机协同学习等。然而,由于语音识别引擎带来的识别错误还难以完全避免,言语个性化及上下文省略带来的语义二义性等因素,计算机应答辞不达意,致使用户困惑,无法完成对话的情况通常可见。

针对这种情况,研究者们在不断提高语音识别率和口语解析算法的同时,也引入基于对话的多模态信息融合的模式,提升计算机对用户意图理解的准确性。尽管如此,多模态信息融合,要使计算机做到和人一样自然流畅交流,并在交互中完成任务依然比较困难,难点首先在于依旧缺乏一种面向交互的有效的多模态信息融合机制;其次在于人机协同期间,目前计算机缺乏有效的从交互中学习知识的机制。

多模态交互性学习是一个非常动态和广泛的研究领域,本文从对话的角度,讨论对话主导的多模态信息融合以及交互学习对于人机协同用户体验的提升。

言语意图理解多模态交互学习的挑战

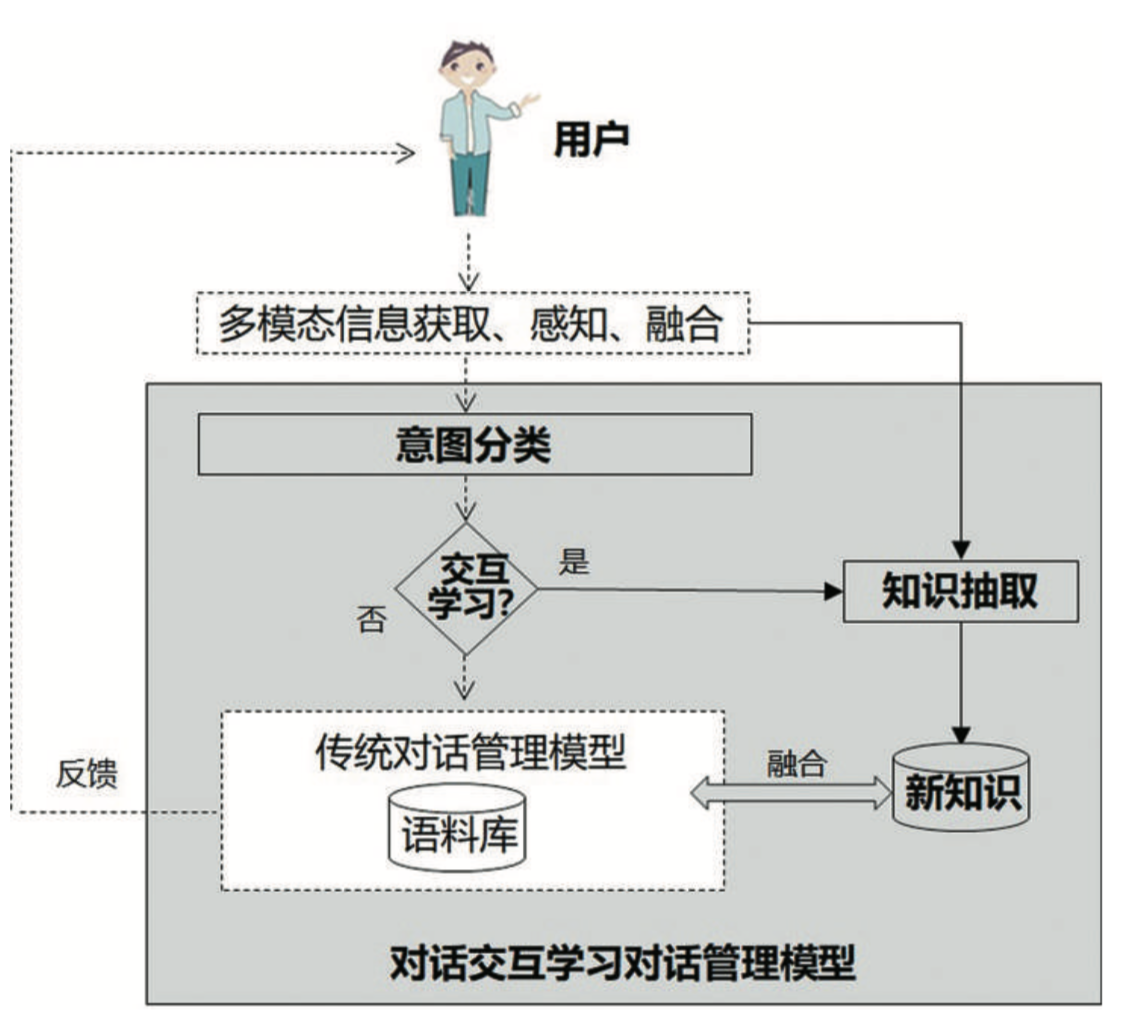

对话主导的多模态交互学习与传统的多模态人机对话相比,除了包含基于多模态信息获取、感知与融合的对话管理模块外,主要不同之处在于,前者具有由意图分类、知识提取、交互知识管理构成的对话交互学习对话管理模型。

图1 具有对话交互学习能力的对话管理模型

图1给出了对话交互学习对话管理模型的多模态人机对话系统结构,其中以虚线连接的白底部分方框是传统的多模态人机对话流程,而实线箭头连接的灰色部分方框构成对话交互学习对话管理模型的重要模块。其中,意图分类主要用于判断当前的对话内容是否包含用户的教授意图,如果处于用户教授状态,则系统转入交互学习状态,需要根据言语知识进行知识提取。如果用户没有教授意图,则系统按照传统模型进行人机对话管理。

有学者将人机对话任务分为任务导向和非任务导向的两种类别,对话交互引入的知识需要根据用户对话意图找到最合适的回答或者反馈。无论任务导向还是非任务导向的人机对话,新旧知识融合的目的在于使得计算机理解了交互学习的知识,其难点在于新知识和原有知识的有效融合。

相对于传统的单一模态交互方式,对话主导的多模态人机交互方式,在移动交互和自然交互存在着更为广泛的应用潜力,如智能家居、智能人机对话、体感交互、教育等。近年来,人工智能技术使得单一模态认知、感知技术,如人脸识别情感理解、手势理解、姿态分析、触觉等性能得到快速提升,计算机能够比较准确理解用户单模态行为。因此,对话主导的多模态人机对话主要的目标及难点均在与如何使得多种交互信息与对话内容有机的结合起来。

对话主导的交互系统,言语信息通常包含了交互任务,然而在一些对话省略的情况下,其他更多的模态对言语中意图的理解有协助作用。如,我们之前根据不同模态对语音交互的影响,把它们与语音信号的关系,处理方式分为三种模式:信息互补模式、信息融合模式和信息独立模式。然后,根据语音识别、表情跟踪和识别、身体姿态跟踪和识别、情感识别的结果,进行用户多模态信息管理。对于多种模态信息融合其真正难点在于各模态信号的表示差别迥异,这使得多种模态信息融合时间点难以得到准确的表达,多模态信息难以统一描述。

自我对话机制对话交互学习的创新探索

根据对话任务的划分,对话交互学习也可以分为非任务导向和任务导向的对话交互学习。

非任务导向的对话交互学习通常发生在用户对计算机的反馈不满意,用户希望能告诉计算机答案,使得计算机快速学习到自己的喜好。例如下面的对话:

用户:“豆腐脑是咸的还是甜的?”

机器人:“有甜的也有咸的,关键看你想怎么样!”

用户:“我觉得咸的更好。”

上述对话中,用户对机器人的回答表达了自己的观点,对于用户观点,在一定程度上可以认为是知识的教授。这种情况下,用户更希望的是机器人能够针对它的观点进行回答,但目前的对话系统往往是直接返回知识库的答案或者给以模棱两可的回复,例如“我也觉得”、“你觉得什么就是什么”等。虽然这样的回复可以减少机器的正面回答及回答的错误率,但带给用户的感觉是计算机并没有领会用户交流或者教授的意图,这样的对话体验并不友好。

为了能够在对话过程中针对用户教授意图,做出与用户教授的内容相关的答案反馈,自动化所副研究员杨明浩提出了一种基于自我对话机制的面向用户教授意图的答案反馈方法,使得计算机能够在与用户的对话过程中,通过自我对话的方式挖掘与当前对话话题相关的更深层次信息,然后综合分析这些信息,对用户进行反馈。其框图如图2所示。

图2 非任务导向的对话学习

基于自我对话机制的用户教授意图的答案提取模型

图2中,用户输入的意图主要有三类:闲聊意图、教授意图以及询问意图。三种意图的主要含义为,闲聊意图是在非教授意图时,算法将默认意图为闲聊意图;教授意图是当用户对话包含人对计算机进行新知识的教授或错误知识的纠正的意图时,属于教授意图;询问意图是主要用来计算对话语句是问句的概率值。三种意图的分类方法采用的是,2016年自动化所语音交互团队提出从历史记录短文本分类方法。后续的对话历史、从互联网公开搜索引擎得到的知识、用户传授知识的融合是核心模块。

如果意图判断为教授意图,根据对话历史来计算历史中当前对话语句对应问题匹配的用户问句;在获得问句后,系统根据问句和用户教授内容到互联网获取相关话题的更多答案;对获取的答案集,将摘要抽取的结果作为对用户对话的反馈。在摘要抽取过程中,如果知识的数量较多,需要先对答案集信息进行聚类,提取与主题更加接近的一组进行摘要抽取,如果信息数量较少,可以直接进行摘要抽取。

基于自我对话机制,面向用户教授意图的对话学习反馈方法,通过启动多个对话代理,将用户的答案引入互联网公开的问答引擎,并模拟多轮对话,将获得的更多答案融合抽取摘要,最后将投票更多的答案返回。实验表明,这种基于自我对话机制,面向用户教授意图的对话学习反馈方法返回的答案,相对于原来的直接返回知识库的答案或者给以模棱两可的回复,给与了用户更好的对话感受。

智能机械臂对话交互的有效应用

面向任务导向的对话学习,相对于非任务导向的对话交互学习,具有更广泛的应用场景,如面向儿童的阅读陪伴、外语学习等。相对于传统的任务导向的人机对话,对话交互学习技术可增加教育产品的趣味性,使得机器人更拟人。2017年,团队研发了一个智能机械臂系统,该系统能够与小孩对话,并且通过对话机交互学习汉字书写方式,包括笔画与笔顺的能力,在儿童教育的陪伴学习方面具有一定价值。

图3 任务导向的对话交互学习:人类书写顺序的智能机械臂

图3给出了对话学习人类书写顺序的智能机械臂大概流程。系统总共分为三个主要模块:信息输入、关键技术以及输出反馈。系统的输入信息模块包含用户的语音信息以及摄像头观察到的文字的图像信息。图3中灰色部分为本系统关键技术模块,主要包含两部分:一是,通过对用户的语音信息进行分析,可以获得用户想要写的关键字及用户意图,并根据当前状态进行对话管理;二是,通过对摄像头看到的图像信息进行分析,对检测到的汉字进行自动笔画拆分和笔顺提取,对于正在教授的字,跟踪笔迹顺序,学习新写法。最后输出反馈,通过对话管理,机械臂会以对话的形式进行反馈与用户交互,并根据调用机械臂的写字程序,书写需要写的字。

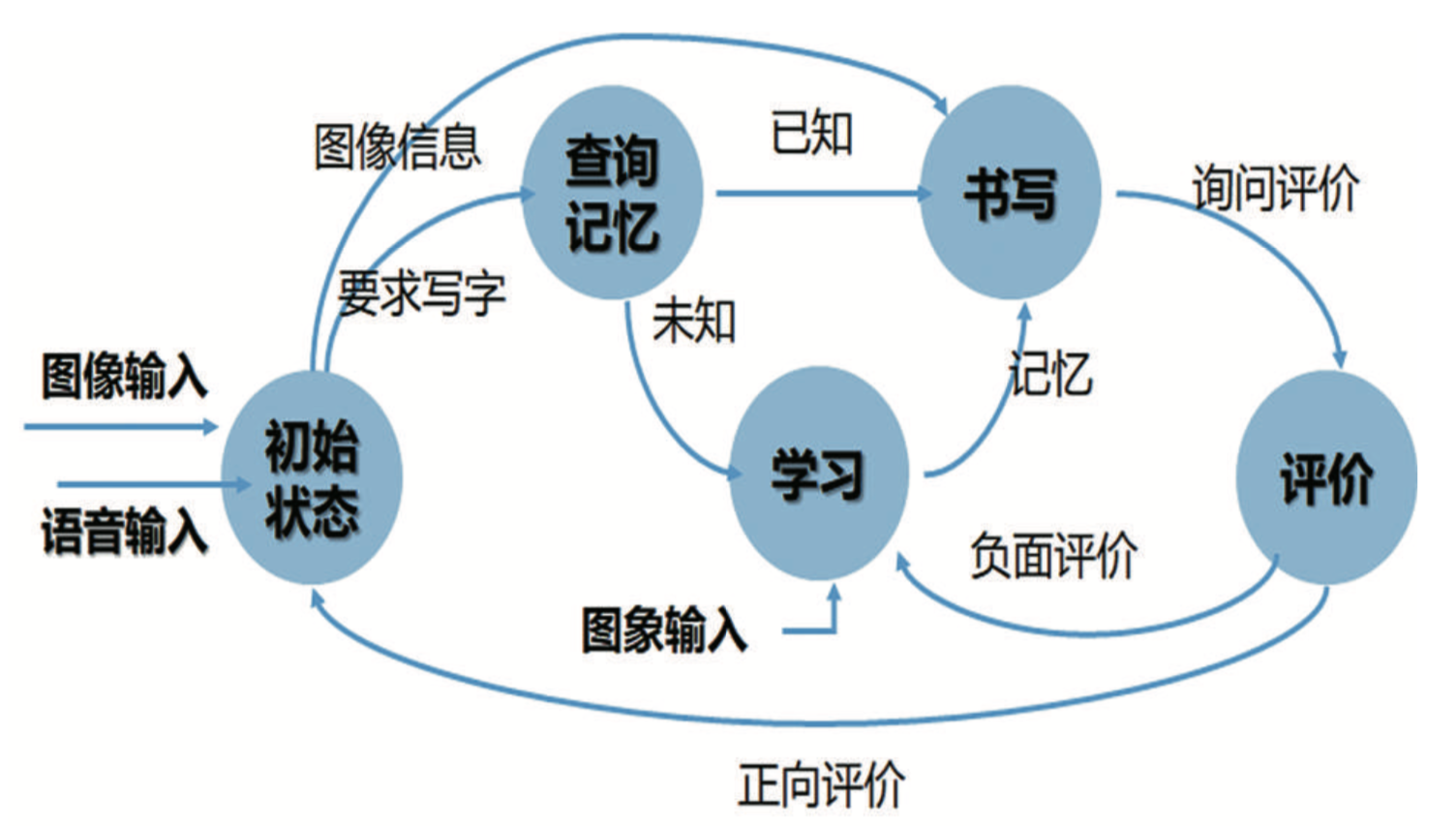

此智能机械臂的多模态对话管理模型如图4所示,对话状态的跳转引导着系统交互学习的过程,共包括“初始状态”“查询记忆”“书写”“学习”“评价”等意图。这些状态分别被来自“用户语音输入”“用户图像输入”“用户写字要求”“用户评价”等多模态信息驱动。

图4 对话学习机械臂的多模态对话管理模型

根据多模态信息融合后的意图分类,机械臂在学习过的知识中没有查到当前书写信息,或者用户给出“负向评价”时,系统进入“学习”状态。当用户对机械臂学习后呈现书写满意时,机械臂记录当前学习的知识到数据库中,完成知识融合。实验中讨论了67名儿童被试者与机械臂系统对话交互学习体验和评测数据,超过2/3的儿童认可这样的陪伴性交互学习系统。

多模态信息融合具有持续增长能力是关键

本文讨论的两个对话交互学习的例子,在新旧知识融合上分别考虑了历史对话信息、互联网开放引擎知识、用户知识的融合以及写字顺序和笔画图象的融合。实际上,人机交互应用中,如家庭服务机器人、智能教育等,用户的行为更加开放自由,交互过程也可能出现更多新的不可预测因素,传统的交互模型以及多模态信息融合方法依旧还需要发展。

要适应人机交互中用户行为自由、交互环境变化的特点,对话交互学习技术需要使得计算机具有伴随人机交互任务,在新的环境里和用户一起学习成长的能力,包括准确判断用户教授意图;准确归纳用户传授知识到已有知识;新旧知识融合后,不影响原有知识的理解准确度,同时新旧知识得到公共增长。目前,已有的人工智能方法部分,对准确判断用户教授意图和准确归纳用户传授知识到已有知识进行了探索,在一些数据集上取得一定的成果,然而在多模态人机交互应用方面,依旧缺乏一个同时满足上诉三个特点的、比较普适的多模态对话交互学习模型。构建出具有增长能力的多模态对话交互学习信息融合模型,使得计算机系统具有在与用户的交互中学习、理解并整合新知识到已有知识的能力,将是多模态自然人机对话技术的一个重要的突破方向。

作者:

杨明浩 副研究员,硕士生导师

陶建华 研究员,博士生导师。中国科学院自动化所所长特聘助理,模式识别国家重点实验室副主任,中欧信息、自动化与应用数学联合实验室主任

(原载于《前沿科学》2019年第2期)