7月23日,卡内基梅隆大学的Alan W Black教授访问自动化所并做客模式识别学术大讲堂,为研究所师生做题为《TTS without the Text: Speech Synthesis in Underresource Languages》的报告。

Black教授是卡内基梅隆大学语言技术研究所的教授。他在英国的考文垂大学获得学士学位后,在英国的爱丁堡大学获得了硕士和博士学位。他先后在日本的ATR公司、英国爱丁堡大学的语音技术研究中心工作或任职,并在1999年加入了卡内基梅隆大学。他是自由软件Festival语音合成系统、FestVox语音工具集以及CMU的Flite语音合成引擎的主要作者之一。Black教授是ISCA(International Speech Communication Association)委员会的成员。他发表过200篇以上的文章或专著,并成为了所在领域引用率最高的作者之一。

报告伊始,Black教授首先介绍了当前语音合成技术为构建合成语音必需具备的条件,包括语料库、文本分析功能、发音词典、音素集的定义以及高层的自然语言处理功能。然而只有很少的语言如英语、汉语完全满足这些条件,部分语言如马拉地语只具备上述条件的大部分,而世界上的大多数语言如孔卡尼语基本上只满足上述条件的很少一部分。Black教授指出的这种现状是普遍存在且在主流的语音合成的研究中较少涉及的,因此这个问题的提出立即吸引了在场老师和同学的注意。

接下来,Black教授介绍到,在众多的资源不丰富的语言中,一个重要的特例是,很多语言只有语音而没有对应的文字。针对这种情况下的语音合成,一种朴素的做法是,用语音识别给出近似的文字识别结果,再用语音合成技术给出合成语音。由于语言不匹配的问题,这种做法是可行的,但结果不太好。稍好一点的做法是以字母为基元进行合成,如果再加上音素特征,则对大多数语言来讲,用梅尔倒谱距离度量的误差确实有所降低。

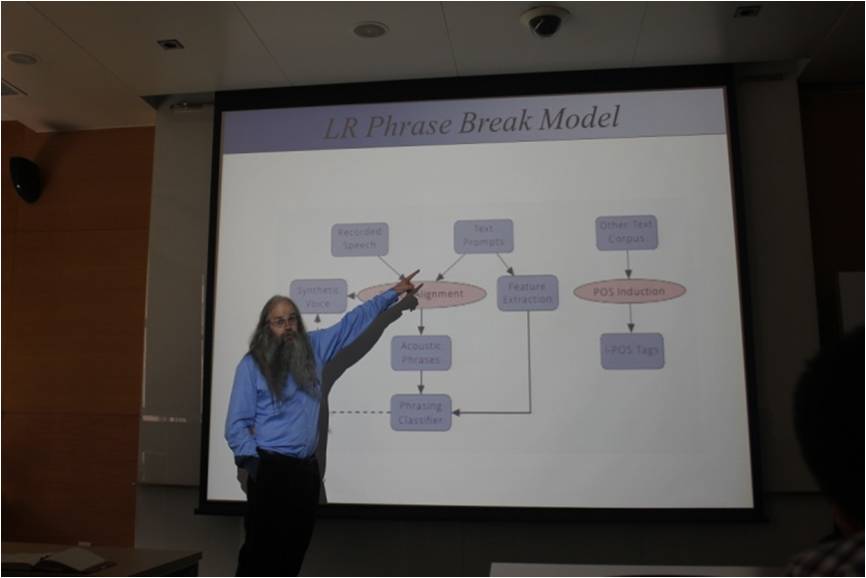

除了对音素的精确描述以外,包括时长模型、语调与短语停顿等在内的韵律模型对合成语音质量也是至关重要的。Black教授分别介绍了基于强制切分的短语停顿模型、基于上下文无关的随机语法模型、以及多层的基频模型等方法来为韵律建模。在上述模型都构建完毕之后,还可以用发音器官的特征推导出更适合于语音合成的虚拟的“音素”。这种语音和发音器官生理参数相结合的研究思路,对资源不丰富的语言的语音合成来说,提供了很好的启发作用。

在讨论环节,Black教授对同学们关心的语调建模问题进行了详细解答,对没有合适的语音识别器的情况下如何进行语音合成也进行了推测。

Black教授的报告取得了积极的反响,开阔了大家的研究视野,为大家向语音合成研究中较少涉及的问题展开探索提供了借鉴。